让你的弹幕更“聪明”:最新研究成果升级视频中人物和背景分割技术

{{sourceReset(detailData.source)}}{{dynamicData.sub_info.subject_name}} 紫牛新闻

{{wholeTimeFilter(detailData.happen_time)}} {{numFilter(detailData.review_count)}}次阅读

{{numFilter(detailData.review_count)}}次阅读

弹幕作为一种新的互动方式,近年来逐渐在各大视频网站推广开来。在享受弹幕带来的陪伴和热闹的同时,你会不会也有观感被影响的时候?如今有一项新的技术可以把视频中的人和背景分割开来,为观众带来更好的体验。

西交利物浦大学智能工程学院学者的研究为这项技术带来新的发展,他们提出的模型在大幅度提升速度的同时还提高了识别的准确率。该研究成果于近日收录于计算机视觉领域顶级IEEE国际计算机视觉与模式识别会议(IEEE Conference on Computer Vision and Pattern Recognition,CVPR),这也是西浦第一篇以第一作者和第一单位身份收录于该会议的文章。

据论文的第一作者、电气与电子工程系博士生孙铭杰介绍,他们的研究使用了强化学习算法来解决如何快速准确地跟踪到视频中的对象,并将其与视频背景进行分离的问题。这项技术能够被广泛应用在视频弹幕、影视制作等领域,未来甚至有可能让电影特技拍摄告别绿幕,直接在复杂背景中进行抠图。

博士生孙铭杰

孙铭杰的指导老师肖继民博士指出,强化学习在人工智能领域内是一项非常前沿的技术,目前关注度很高,比如战胜了围棋世界冠军的人工智能机器人AlphaGo就是其中的知名应用。“使用强化学习算法研究视频对象跟踪与分割的过程中有一些很容易被忽视的技术难点,作为老师应该鼓励博士生紧跟这些最前沿的技术,挑战有技术深度和应用前景的课题。”

孙铭杰把研究重点放在目标模版的判定这一细节上。通过使用强化学习算法训练模型,它可以智能、自主地完成“是否要用新的识别对象去替换原有的目标模板”这一决策判定。 “当计算机识别视频中的对象时,首先需要一个参照物来和视频中的对象比对,这个参照物就被称作目标模版,它可能是被识别对象的照片或者其在其他视频中的截图。”

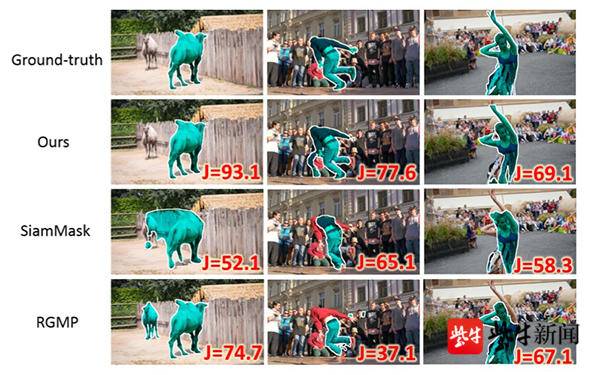

研究示意图

他解释道:“当计算机根据目标模板识别出了视频中某一帧的对象后,理论上来说这一帧的对象是可以替换原有的目标模板来进行后续信息识别的,因为它更接近视频里的真实信息。但因为视频是动态的,可能这一帧的精确度并不高,或者周围有遮挡物,如果这种情况下依旧用它进行后续识别的话,识别的精确度就会下降,甚至会导致目标模版损坏、无法继续识别。”

孙铭杰表示,在使用强化学习算法训练这个模型后,它可以主动学习提升,能够像一个“智能开关”一样自主决定是否需要替换模板,“和以前手写很多规则的解决办法相比,我们提出的模型覆盖的规则更为全面,而且节省人力。”

测试结果表明,他们的模型在速度和质量两方面都有所提升,对视频对象进行追踪与分割的工作效率明显优于其他几组。

从左到右依次为:林永义教授、孙铭杰、肖继民博士

孙铭杰是由西浦智能工程学院院长林永义教授和肖继民博士共同指导的博士生。林院长表示,作为博士生第一年的研究项目就可以成为西浦首篇发表在CVPR会议上的文章,这是对学生探索能力和老师教学能力的肯定。“在这个过程中,不论师生都颇有收获,这也是我们在做科研的过程中紧贴研究导向型教学理念的一种体现。”

扬子晚报/紫牛新闻记者 顾秋萍 通讯员:胡秋辰 金画恬

编辑 : 陶善工

更多内容请打开紫牛新闻, 或点击链接